들어가며

이번 포스팅은 CloudNet@ 커뮤니티에서 주최하는 KANS 스터디 5주 차 주제인 "Service-LoadBalancer Type"에 대해서 정리한 내용입니다.

k8s Service - LoadBalancer Type

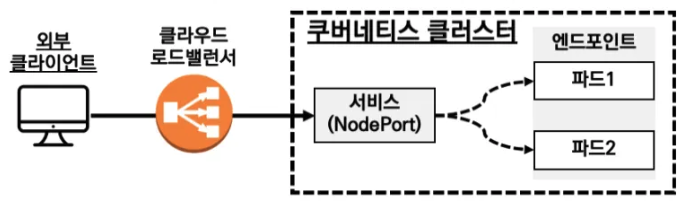

LoadBalancer Type의 서비스는 클러스터 외부로 서비스를 노출시키기 위해 사용합니다. 주로 클라우드 환경에서 사용되며, 클라우드 제공업체들의 로드 밸런서 기능을 활용하여 외부 트래픽을 클러스터내의 특정 서비스로 라우팅하는 형태로 사용합니다.

Loadbalancer는 클라우드 제공업체의 네이티브 로드 밸런서를 사용하므로 AWS와 같은 클라우드 환경에서 잘 동작합니다. 그렇기 때문에 온프레미스 환경에서는 소프트웨어 로드밸런서 또는 물리 로드밸런서와 같은 솔루션을 사용해아합니다.

Loadbalancer 서비스는 퍼블릭 클라우드 사업자 또는 물리 하드웨어 별로 동작에 조금씩 차이가 있습니다.

외부 단말로 부터 Loadbalancer서비스를 통해 서비스로 접속하는 형태를 그림으로 나타내자면 다음과 같습니다.

(해당 그림에서는 소프트웨어 로드밸런서를 사용, 예: MetalLB)

Public Cloud(AWS) 환경의 LoadBalancer 서비스 동작방식

AWS는 관리형 LoladBalancer 서비스인 ELB(Elastic Load Balancing)가 있습니다.

ELB는 세가지 종류인 CLB, NLB, ALB 를 제공합니다.

CLB(Classic Load Balancing)

NLB/ALB에 비해 가장 적은 기능을 제공하며 가장 오래된 로드밸런서입니다.

NLB(Network Load Balancing)

CLB/ALB에 비해 처리속도가 가장 빠르고 Layer4 계층에서 동작합니다. TCP/UDP/TLS 트래픽을 처리할 수 있습니다.

ALB(Application loadbanacer)

HTTP/HTTPS/gRPC 트래픽을 전문으로 처리하며, Layer7 계층에서 동작합니다.

쿠버네티스에서 LoadBalancer 서비스 리소를 생성할 때 CLB 또는 NLB가 생성되어 노드에 있는 파드로 연결됩니다. Ingress 리소스를 생성하게되면 ALB가 생성됩니다.

클라우드 환경의 LoadBalancer 서비스

클라우드 로드벨런서를 활용하는 방법은 두가지 종류가 있습니다.

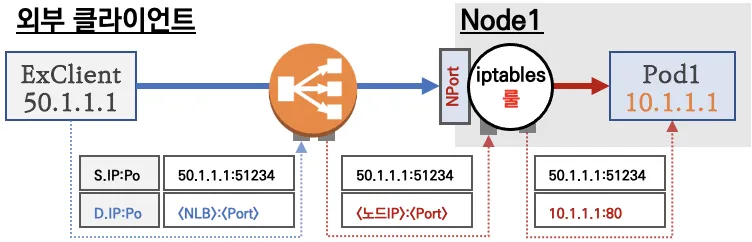

첫 번째 방식은 노드의 NodePort를 로드밸런서로 연결하여 부하분산을 구성하는 방법인데, 이때는 부하분산과정이 두번 수행하기 때문에 비효율 적입니다.

두 번째 방식은 쿠버네티스의 로드밸런서 컨트롤러를 이용하여 클라우드 로드밸런서를 Pod와 다이렉트로 연결하는 방법입니다.

온프레미스 환경의 LoadBalancer 서비스

온프레미스에서 동작하는 LoadBalancer서비스는 하드웨어 장비 기반 동작과, 소프트웨어 기반 동작으로 나뉘게 됩니다.

첫 번째 방식인 하드웨어 장비 기반 동작은, 앞서 설명드린 두가지의 방식과 동일한 형태로 사용을 하되, 관리형 서비스 Loadbalancer를 사용하는 것이 아니라, 하드웨어를 사용한다는 차이가 있습니다.

두번째 방식인 소프트웨어 기반 동작은 쿠버네티스 클러스터 내부에 로드밸런싱을 수행하는 Pod를 배치하여 통신을 수행하게 됩니다. 대표적인 소프트웨어 방식의 LoadBalancer인 MetalLB에 대해서 좀 더 살펴 보도록 하겠습니다.

MetalLB

MetalLB는 BareMetalLoadBalancer의 약자로, 온프레미스 환경에서 표준 프로토콜을 사용하여 LoadBalancer 서비스를 구현해 주는 오픈소스입니다.

쿠버네티스의 DaemonSet을 이용하여 스피커 파드를 생성하여 "External IP"를 전파합니다. External IP는 노드의 IP를 노출하지 않고, 외부에서 접속을 할 수 있는 환경을 제공하여 클러스터의 보안성을 높일 수 있습니다.

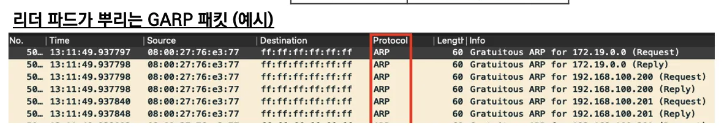

External IP의 전파 방식은 ARP를 사용하는 Layer2모드와 BGP를 사용하는 BGP 모드 중 하나를 사용할 수 있습니다.

(ARP 모드를 사용할 경우에는 대부분의 퍼블릭 클라우드 플랫폼 환경에서 ARP요청을 차단하기 때문에 동작하지 않습니다.)

MetalLB-Layer 2 Mode

Layer2 모드는 ARP를 통해서 External IP를 전파합니다.

ARP (Address Resolution Protocol)는 네트워크에서 IP 주소를 사용하여 물리적 주소(즉, MAC 주소)를 찾아주는 프로토콜입니다.

(주로 IPv4 네트워크에서 사용되며, 로컬 네트워크 내에서 IP 패킷을 정확한 장치로 전달하기 위해 필요합니다.)

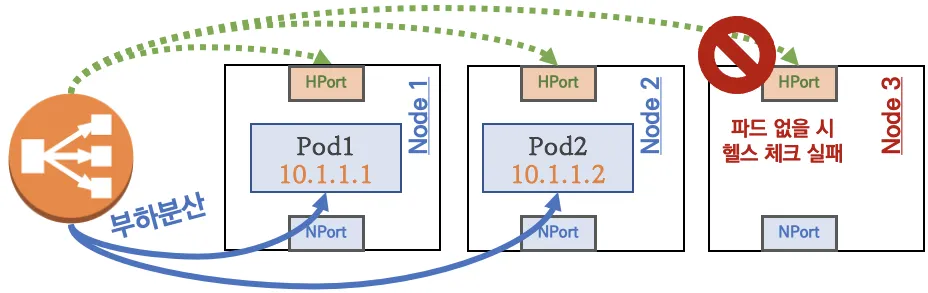

LoadBalancer 서비스 리소스 생성시 MetalLB 스피커 파드들 중 Leader 스피커 파드가 선출됩니다. 리더 스피커파드는 해당 LoadBalancer서비스의 External IP를 전파합니다. Layer2모드 이기 때문에 ARP 메시지를 이용하여 동일 네트워크 대역내에 브로드캐스트 주소로 전파합니다. 리더 스피커 파드가 장애 발생시, 나머지 스피커 파드 중 리더가 다시 선택됩니다.

클라이언트가 SVC의 External IP로 접속을 시도하게 되면, 리더 스피커 파드가 있는 노드로 들어오고, iptables의 규칙에 의해 여러 Pod들로 부하분산되는 형태입니다.

스터디에서는 테스트 및 소규모 환경(동일 네트워크 1개 사용)에서 사용하는 것이 적절할 것 같다고 했습니다. 대규모 시스템에서는 ARP 만으로도 많은 오버헤드가 발생할 수 있고 비효율 적이기 때문입니다.

또한 single-node bottlenecking(서비스 1개 생성 사용 시, 모든 서비스 접근 트래픽이 리더 파드가 존재하는 노드로만 인입되어 부하가 집중됨), potentially slow failover(리더(노드)가 장애 시 새로운 리더 선출까지 10~20초 정도 딜레이 발생)와 같은 이슈들도 존재한다고 합니다.

MetalLB-BGP 모드

BGP 모드는 각 노드의 speaker 파드가 BGP로 서비스 정보(EXTERNAL-IP)를 전파 후, 외부에서 라우터를 통해 ECMP 라우팅으로 부하 분산 접속을 하게 됩니다. Service External IPs는 외부에서 접근할 수 있는 서비스 IP들이 표시됩니다. 라우터에서는 이러한 IP 주소를 통해 Node1, Node2, Node3와 같은 클러스터로 트래픽을 분산하여 처리합니다.

하지만 이러한 모드를 사용하려면 네트워크 팀과 협업이 매우 필요해 보입니다.

스터디의 관점에서는 다음과 같은 작업이 필요하다고 합니다.

- 노드(speaker) 파드 장애 시 BGP Timer 설정 등 구성하고 있는 네트워크 환경에 맞게 최적화 작업이 필요

- ECMP 부하 분산 접속 시 특정 파드에 몰리거나 혹은 세션 고정, flapping 등 다양한 환경에 대응이 필요

- BGP 라우팅 설정 및 라우팅 전파 관련 최적화 설정이 필요

MetalLB Layer 2 Mode 실습환경 구성

cat <<EOT> kind-svc-2w.yaml

kind: Cluster

apiVersion: kind.x-k8s.io/v1alpha4

featureGates:

"InPlacePodVerticalScaling": true #실행 중인 파드의 리소스 요청 및 제한을 변경할 수 있게 합니다.

"MultiCIDRServiceAllocator": true #서비스에 대해 여러 CIDR 블록을 사용할 수 있게 합니다.

nodes:

- role: control-plane

labels:

mynode: control-plane

topology.kubernetes.io/zone: ap-northeast-2a

extraPortMappings: #컨테이너 포트를 호스트 포트에 매핑하여 클러스터 외부에서 서비스에 접근할 수 있도록 합니다.

- containerPort: 30000

hostPort: 30000

- containerPort: 30001

hostPort: 30001

- containerPort: 30002

hostPort: 30002

- containerPort: 30003

hostPort: 30003

- containerPort: 30004

hostPort: 30004

kubeadmConfigPatches:

- |

kind: ClusterConfiguration

apiServer:

extraArgs: #API 서버에 추가 인수를 제공

runtime-config: api/all=true #모든 API 버전을 활성화

controllerManager:

extraArgs:

bind-address: 0.0.0.0

etcd:

local:

extraArgs:

listen-metrics-urls: http://0.0.0.0:2381

scheduler:

extraArgs:

bind-address: 0.0.0.0

- |

kind: KubeProxyConfiguration

metricsBindAddress: 0.0.0.0

- role: worker

labels:

mynode: worker1

topology.kubernetes.io/zone: ap-northeast-2a

- role: worker

labels:

mynode: worker2

topology.kubernetes.io/zone: ap-northeast-2b

- role: worker

labels:

mynode: worker3

topology.kubernetes.io/zone: ap-northeast-2c

networking:

podSubnet: 10.10.0.0/16 #파드 IP를 위한 CIDR 범위를 정의합니다. 파드는 이 범위에서 IP를 할당받습니다.

serviceSubnet: 10.200.1.0/24 #서비스 IP를 위한 CIDR 범위를 정의합니다. 서비스는 이 범위에서 IP를 할당받습니다.

EOT

# k8s 클러스터 설치

kind create cluster --config kind-svc-2w.yaml --name myk8s --image kindest/node:v1.31.0

docker ps

# 노드에 기본 툴 설치

docker exec -it myk8s-control-plane sh -c 'apt update && apt install tree psmisc lsof wget bsdmainutils bridge-utils net-tools dnsutils ipset ipvsadm nfacct tcpdump ngrep iputils-ping arping git vim arp-scan -y'

for i in worker worker2 worker3; do echo ">> node myk8s-$i <<"; docker exec -it myk8s-$i sh -c 'apt update && apt install tree psmisc lsof wget bsdmainutils bridge-utils net-tools dnsutils ipset ipvsadm nfacct tcpdump ngrep iputils-ping arping -y'; echo; done

# k8s v1.31.0 버전 확인

kubectl get node

# 노드 labels 확인

kubectl get nodes -o jsonpath="{.items[*].metadata.labels}" | jq

# kind network 중 컨테이너(노드) IP(대역) 확인

docker ps -q | xargs docker inspect --format '{{.Name}} {{.NetworkSettings.Networks.kind.IPAddress}}'

# 파드CIDR 과 Service 대역 확인 : CNI는 kindnet 사용

kubectl get cm -n kube-system kubeadm-config -oyaml | grep -i subnet

kubectl cluster-info dump | grep -m 2 -E "cluster-cidr|service-cluster-ip-range"

# MultiCIDRServiceAllocator : https://kubernetes.io/docs/tasks/network/extend-service-ip-ranges/

kubectl get servicecidr

NAME CIDRS AGE

kubernetes 10.200.1.0/24 2m13s

# 노드마다 할당된 dedicated subnet (podCIDR) 확인

kubectl get nodes -o jsonpath="{.items[*].spec.podCIDR}"

10.10.0.0/24 10.10.4.0/24 10.10.3.0/24 10.10.1.0/24

# kube-proxy configmap 확인

kubectl describe cm -n kube-system kube-proxy

...

mode: iptables

iptables:

localhostNodePorts: null

masqueradeAll: false

masqueradeBit: null

minSyncPeriod: 1s

syncPeriod: 0s

...

# 노드 별 네트워트 정보 확인 : CNI는 kindnet 사용

for i in control-plane worker worker2 worker3; do echo ">> node myk8s-$i <<"; docker exec -it myk8s-$i cat /etc/cni/net.d/10-kindnet.conflist; echo; done

for i in control-plane worker worker2 worker3; do echo ">> node myk8s-$i <<"; docker exec -it myk8s-$i ip -c route; echo; done

for i in control-plane worker worker2 worker3; do echo ">> node myk8s-$i <<"; docker exec -it myk8s-$i ip -c addr; echo; done

# iptables 정보 확인

for i in filter nat mangle raw ; do echo ">> IPTables Type : $i <<"; docker exec -it myk8s-control-plane iptables -t $i -S ; echo; done

for i in filter nat mangle raw ; do echo ">> IPTables Type : $i <<"; docker exec -it myk8s-worker iptables -t $i -S ; echo; done

for i in filter nat mangle raw ; do echo ">> IPTables Type : $i <<"; docker exec -it myk8s-worker2 iptables -t $i -S ; echo; done

for i in filter nat mangle raw ; do echo ">> IPTables Type : $i <<"; docker exec -it myk8s-worker3 iptables -t $i -S ; echo; done

# 각 노드 bash 접속

docker exec -it myk8s-control-plane bash

docker exec -it myk8s-worker bash

docker exec -it myk8s-worker2 bash

docker exec -it myk8s-worker3 bash

----------------------------------------

exit

----------------------------------------

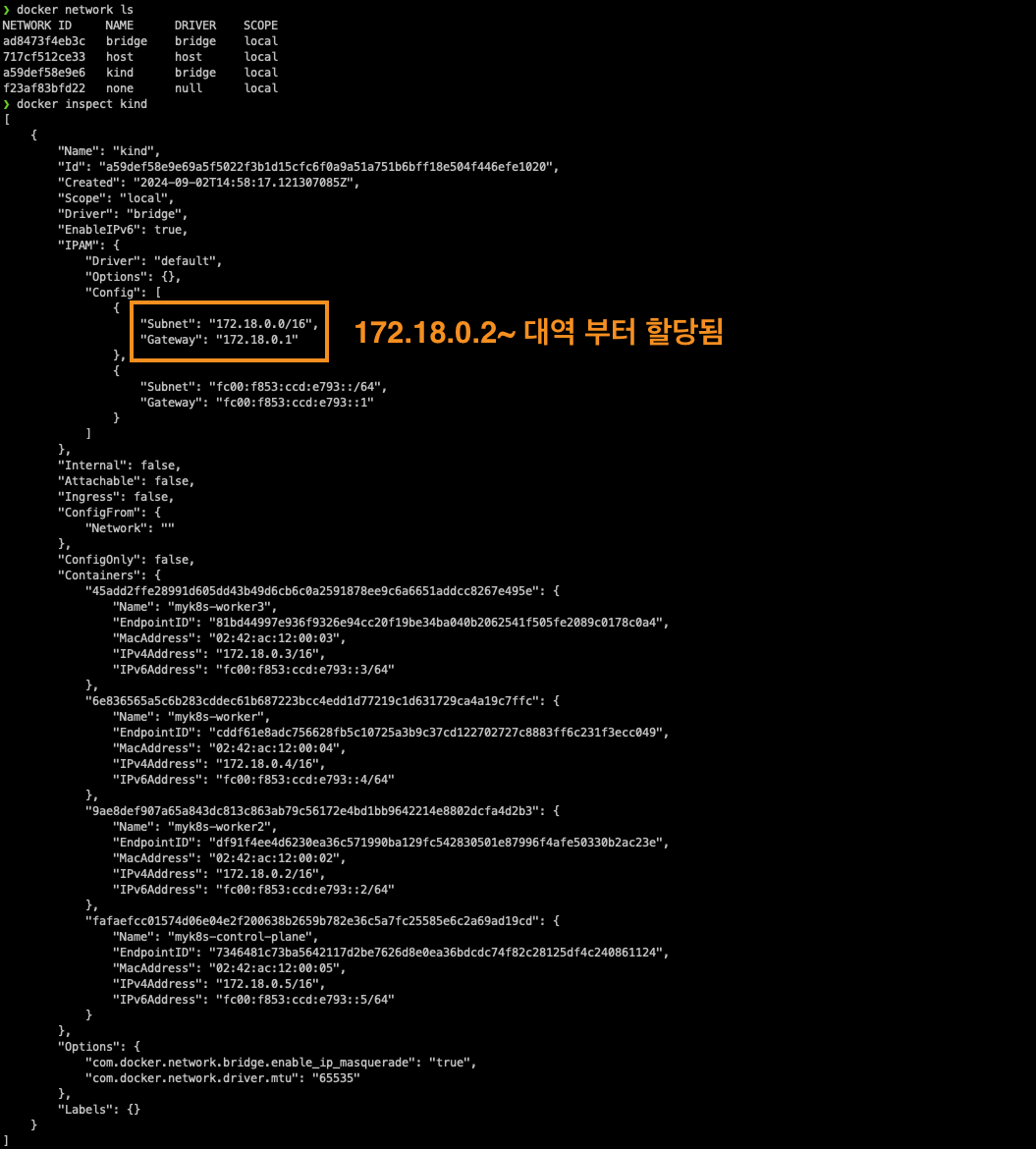

# kind 설치 시 kind 이름의 도커 브리지가 생성된다 : 172.18.0.0/16 대역

docker network ls

docker inspect kind

# arp scan 해두기

docker exec -it myk8s-control-plane arp-scan --interfac=eth0 --localnet

# mypc 컨테이너 기동 : kind 도커 브리지를 사용하고, 컨테이너 IP를 지정 없이 혹은 지정 해서 사용

docker run -d --rm --name mypc --network kind --ip 172.18.0.100 nicolaka/netshoot sleep infinity # IP 지정 실행 시

IP 지정 실행 시 에러 발생 시 아래 처럼 IP 지정 없이 실행

docker run -d --rm --name mypc --network kind nicolaka/netshoot sleep infinity # IP 지정 없이 실행 시

docker ps

# mypc2 컨테이너 기동 : kind 도커 브리지를 사용하고, 컨테이너 IP를 지정 없이 혹은 지정 해서 사용

docker run -d --rm --name mypc2 --network kind --ip 172.18.0.200 nicolaka/netshoot sleep infinity # IP 지정 실행 시

IP 지정 실행 시 에러 발생 시 아래 처럼 IP 지정 없이 실행

docker run -d --rm --name mypc2 --network kind nicolaka/netshoot sleep infinity # IP 지정 없이 실행 시

docker ps

# kind network 중 컨테이너(노드) IP(대역) 확인

docker ps -q | xargs docker inspect --format '{{.Name}} {{.NetworkSettings.Networks.kind.IPAddress}}'

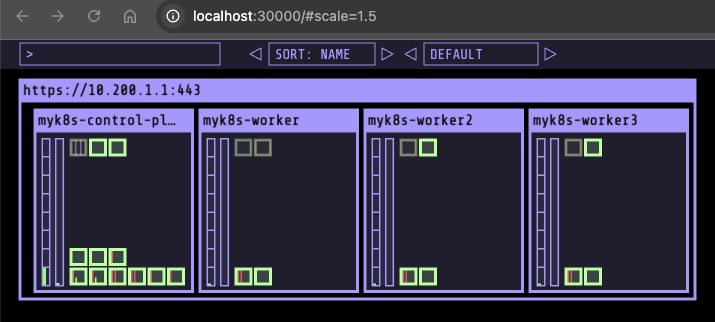

# kube-ops-view 설치

helm repo add geek-cookbook https://geek-cookbook.github.io/charts/

helm install kube-ops-view geek-cookbook/kube-ops-view --version 1.2.2 --set service.main.type=NodePort,service.main.ports.http.nodePort=30000 --set env.TZ="Asia/Seoul" --namespace kube-system

# myk8s-control-plane 배치

kubectl -n kube-system edit deploy kube-ops-view

---

spec:

...

template:

...

spec:

nodeSelector:

mynode: control-plane

tolerations:

- key: "node-role.kubernetes.io/control-plane"

operator: "Equal"

effect: "NoSchedule"

---

# 설치 확인

kubectl -n kube-system get pod -o wide -l app.kubernetes.io/instance=kube-ops-view

# kube-ops-view 접속 URL 확인 (1.5 , 2 배율) : macOS 사용자

echo -e "KUBE-OPS-VIEW URL = http://localhost:30000/#scale=1.5"

echo -e "KUBE-OPS-VIEW URL = http://localhost:30000/#scale=2"

# kube-ops-view 접속 URL 확인 (1.5 , 2 배율) : Windows 사용자

echo -e "KUBE-OPS-VIEW URL = http://192.168.50.10:30000/#scale=1.5"

echo -e "KUBE-OPS-VIEW URL = http://192.168.50.10:30000/#scale=2"

# kube-ops-view 접속 URL 확인 (1.5 , 2 배율) : AWS_EC2 사용자

echo -e "KUBE-OPS-VIEW URL = http://$(curl -s ipinfo.io/ip):30000/#scale=1.5"

echo -e "KUBE-OPS-VIEW URL = http://$(curl -s ipinfo.io/ip):30000/#scale=2"

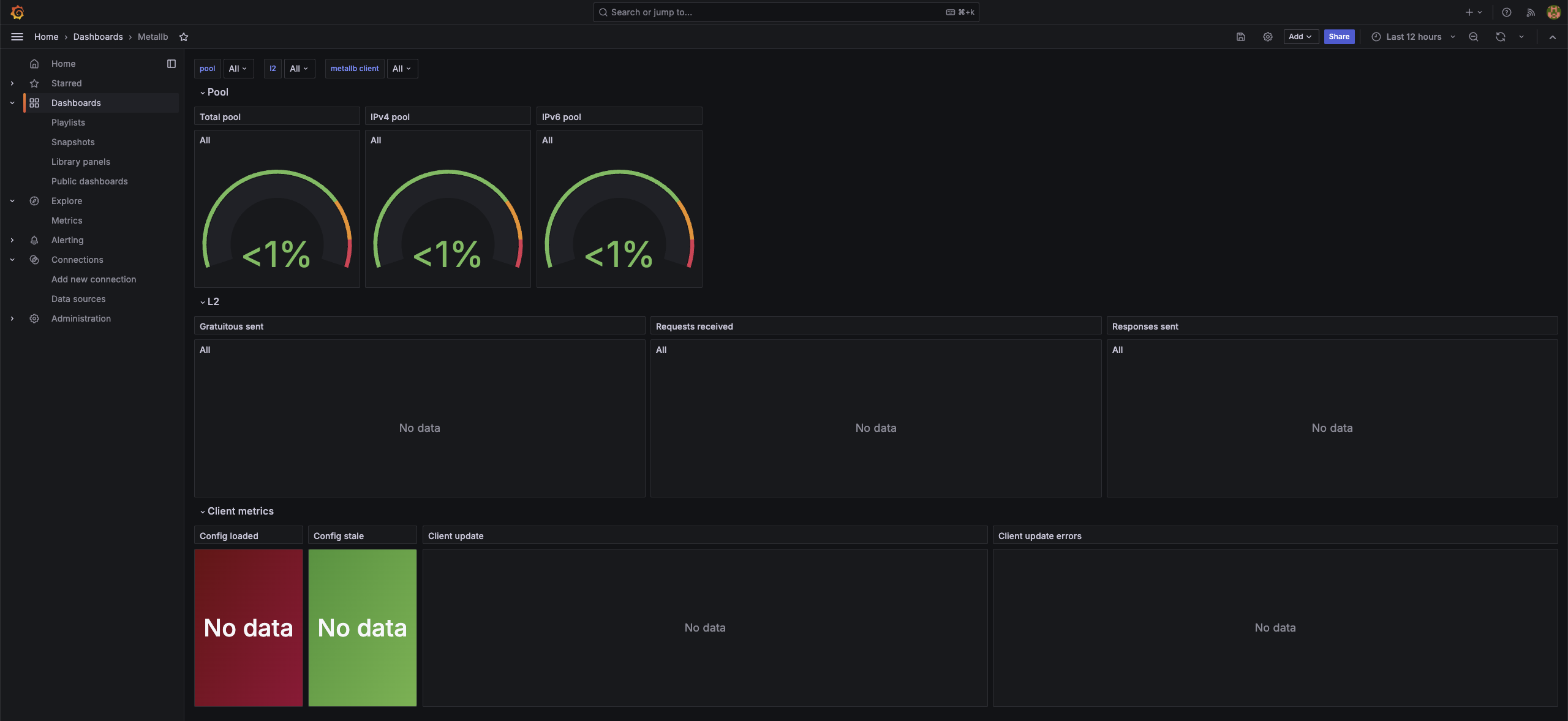

#프로메테우스 스택 설치

helm repo add prometheus-community https://prometheus-community.github.io/helm-charts

# 파라미터 파일 생성

cat <<EOT > monitor-values.yaml

prometheus:

service:

type: NodePort

nodePort: 30001

prometheusSpec:

podMonitorSelectorNilUsesHelmValues: false

serviceMonitorSelectorNilUsesHelmValues: false

nodeSelector:

mynode: control-plane

tolerations:

- key: "node-role.kubernetes.io/control-plane"

operator: "Equal"

effect: "NoSchedule"

grafana:

defaultDashboardsTimezone: Asia/Seoul

adminPassword: kans1234

service:

type: NodePort

nodePort: 30002

nodeSelector:

mynode: control-plane

tolerations:

- key: "node-role.kubernetes.io/control-plane"

operator: "Equal"

effect: "NoSchedule"

sidecar:

dashboards:

enabled: true

dashboards:

default:

custom-dashboard:

gnetId: 20162 # MetalLB 대시보드 ID

datasource: Prometheus # 사용할 데이터소스 이름을 명시

revision: 1 # 대시보드의 버전

defaultRules:

create: false

alertmanager:

enabled: false

EOT

# 배포

kubectl create ns monitoring

helm install kube-prometheus-stack prometheus-community/kube-prometheus-stack --version 62.3.0 -f monitor-values.yaml --namespace monitoring

# 확인

helm list -n monitoring

# Grafana 접속 계정 : admin / kans1234 : macOS 사용자

echo -e "Prometheus URL = http://localhost:30001"

echo -e "Grafana URL = http://localhost:30002"

# Grafana 접속 계정 : admin / kans1234 : Windows 사용자

echo -e "Prometheus URL = http://192.168.50.10:30001"

echo -e "Grafana URL = http://192.168.50.10:30002"

# Grafana 접속 계정 : admin / kans1234 : AWS_EC2 사용자

echo -e "Prometheus URL = http://$(curl -s ipinfo.io/ip):30001"

echo -e "Grafana URL = http://$(curl -s ipinfo.io/ip):30002"

prometheus stack 설치 및 그라파나 모니터링 연결

로드밸런서는 쿠버네티스 외부로 서비스를 노출시키는데 사용합니다.

쿠버네티스는 자체적인 로드벨런서 컨트롤러가 없다.

MetalLB Layer 2 Mode 실습

cat <<EOF | kubectl apply -f -

apiVersion: v1

kind: Pod

metadata:

name: webpod1

labels:

app: webpod

spec:

nodeName: myk8s-worker

containers:

- name: container

image: traefik/whoami

terminationGracePeriodSeconds: 0

---

apiVersion: v1

kind: Pod

metadata:

name: webpod2

labels:

app: webpod

spec:

nodeName: myk8s-worker2

containers:

- name: container

image: traefik/whoami

terminationGracePeriodSeconds: 0

EOF

# 파드 정보 확인

kubectl get pod -owide

# 파드 IP주소를 변수에 지정

WPOD1=$(kubectl get pod webpod1 -o jsonpath="{.status.podIP}")

WPOD2=$(kubectl get pod webpod2 -o jsonpath="{.status.podIP}")

echo $WPOD1 $WPOD2

# 접속 확인

docker exec -it myk8s-control-plane ping -i 1 -W 1 -c 1 $WPOD1

docker exec -it myk8s-control-plane ping -i 1 -W 1 -c 1 $WPOD2

docker exec -it myk8s-control-plane curl -s --connect-timeout 1 $WPOD1 | grep Hostname

docker exec -it myk8s-control-plane curl -s --connect-timeout 1 $WPOD2 | grep Hostname

docker exec -it myk8s-control-plane curl -s --connect-timeout 1 $WPOD1 | egrep 'Hostname|RemoteAddr|Host:'

docker exec -it myk8s-control-plane curl -s --connect-timeout 1 $WPOD2 | egrep 'Hostname|RemoteAddr|Host:'

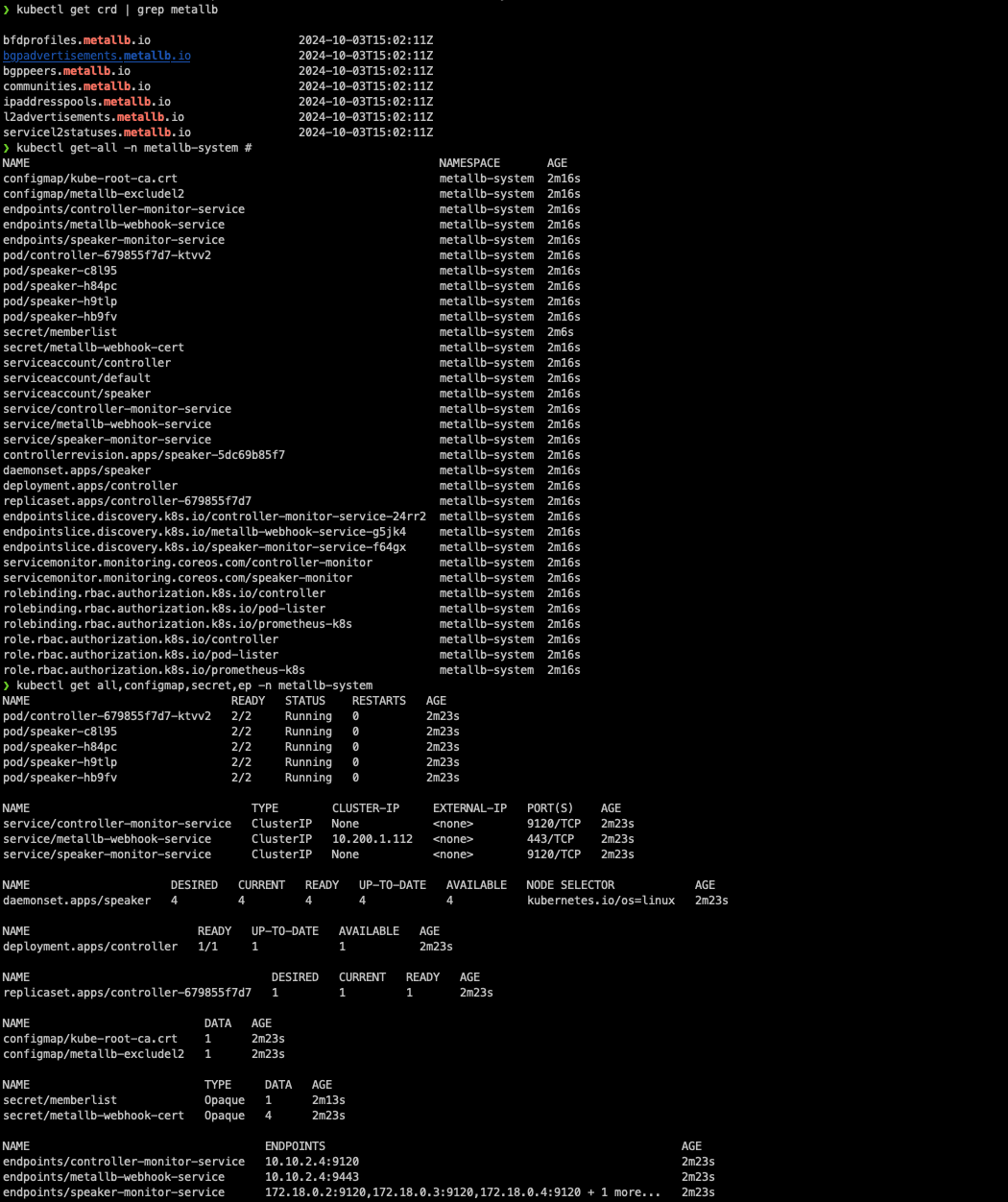

manifests를 이용하여 metallb-native-prometheus를 설치합니다.

# Kubernetes manifests 로 설치

#kubectl apply -f https://raw.githubusercontent.com/metallb/metallb/v0.14.8/config/manifests/metallb-native.yaml

kubectl apply -f https://raw.githubusercontent.com/metallb/metallb/refs/heads/main/config/manifests/metallb-native-prometheus.yaml

# metallb crd 확인

kubectl get crd | grep metallb

bfdprofiles.metallb.io 2024-09-28T15:24:06Z

bgpadvertisements.metallb.io 2024-09-28T15:24:06Z

bgppeers.metallb.io 2024-09-28T15:24:06Z

communities.metallb.io 2024-09-28T15:24:06Z

ipaddresspools.metallb.io 2024-09-28T15:24:06Z

l2advertisements.metallb.io 2024-09-28T15:24:06Z

servicel2statuses.metallb.io 2024-09-28T15:24:06Z

# 생성된 리소스 확인 : metallb-system 네임스페이스 생성, 파드(컨트롤러, 스피커) 생성, RBAC(서비스/파드/컨피그맵 조회 등등 권한들), SA 등

kubectl get-all -n metallb-system # kubectl krew 플러그인 get-all 설치 후 사용 가능

kubectl get all,configmap,secret,ep -n metallb-system

# 파드 내에 kube-rbac-proxy 컨테이너는 프로메테우스 익스포터 역할 제공

kubectl get pods -n metallb-system -l app=metallb -o jsonpath="{range .items[*]}{.metadata.name}{':\n'}{range .spec.containers[*]}{' '}{.name}{' -> '}{.image}{'\n'}{end}{end}"

## metallb 컨트롤러는 디플로이먼트로 배포됨

kubectl get ds,deploy -n metallb-system

## 데몬셋으로 배포되는 metallb 스피커 파드의 IP는 네트워크가 host 모드이므로 노드의 IP를 그대로 사용

kubectl get pod -n metallb-system -o wide

NAME READY STATUS RESTARTS AGE IP NODE NOMINATED NODE READINESS GATES

controller-679855f7d7-2dvbm 2/2 Running 0 9m17s 10.10.2.6 myk8s-worker3 <none> <none>

speaker-jfvh9 2/2 Running 0 9m17s 172.18.0.2 myk8s-worker <none> <none>

speaker-l2tdn 2/2 Running 0 9m17s 172.18.0.5 myk8s-worker3 <none> <none>

speaker-pzs8z 2/2 Running 0 9m17s 172.18.0.3 myk8s-worker2 <none> <none>

speaker-vfsdj 2/2 Running 0 9m17s 172.18.0.4 myk8s-control-plane <none> <none>

# (참고) 상세 정보 확인

kubectl get sa,cm,secret -n metallb-system

kubectl describe role -n metallb-system

kubectl describe deploy controller -n metallb-system

kubectl describe ds speaker -n metallb-system

여기서 speaker pod에 컨테이너가 2개인 이유는 prometheus exporter가 동작하기 때문입니다.

다음으로 모드와 서비스 대역을 지정하기 위해 컨피그맵을 생성합니다. 이 때 External-IP 대역을 노드가 속한 eth0의 대역외에 다른 대역을 써도 상관없다고 합니다. 다만 이런 경우에는 GW역할의 라우터에서 노드들로 라우팅경로를 지정해 줘야합니다.

# kind 설치 시 kind 이름의 도커 브리지가 생성된다 : 172.18.0.0/16 대역

docker network ls

docker inspect kind

# kind network 중 컨테이너(노드) IP(대역) 확인 : 172.18.0.2~ 부터 할당되며, control-plane 이 꼭 172.18.0.2가 안될 수 도 있음

docker ps -q | xargs docker inspect --format '{{.Name}} {{.NetworkSettings.Networks.kind.IPAddress}}'

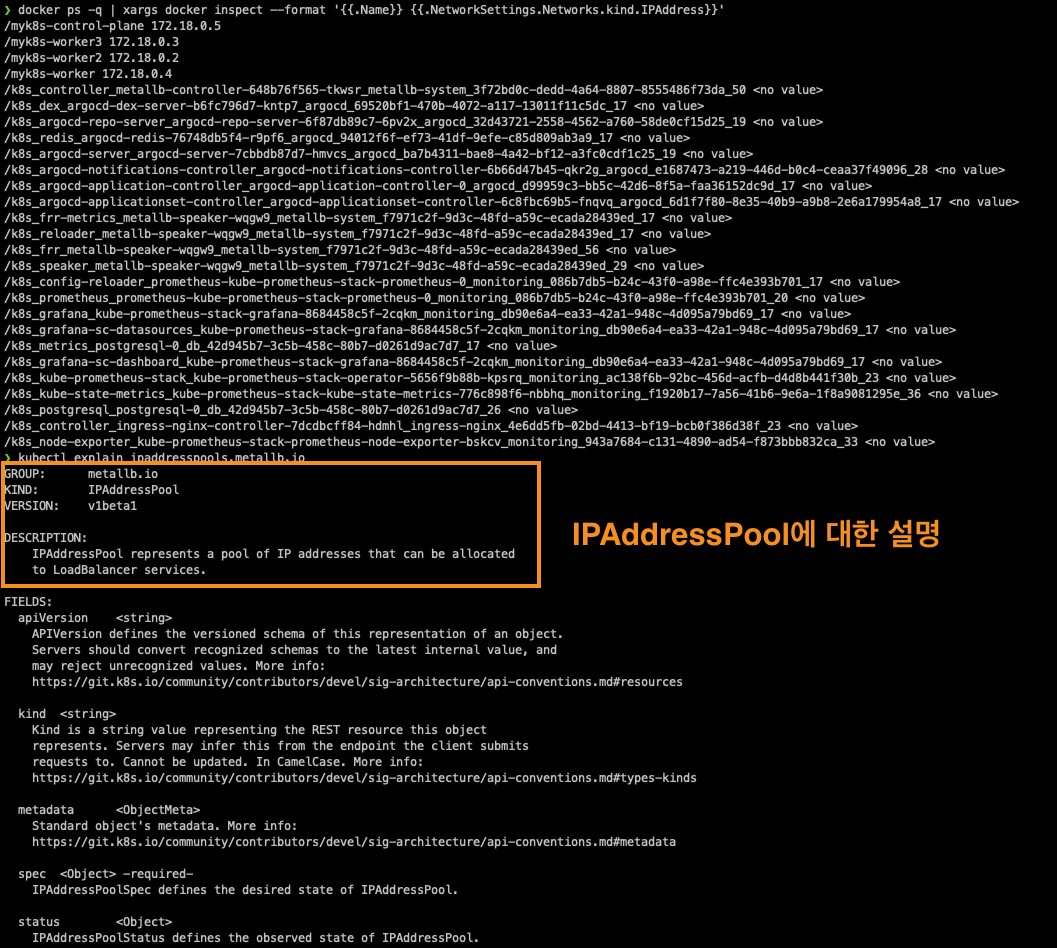

# IPAddressPool 생성 : LoadBalancer External IP로 사용할 IP 대역

## MetalLB는 서비스를 위한 외부 IP 주소를 관리하고, 서비스가 생성될 때 해당 IP 주소를 동적으로 할당할 수 있습니다.

kubectl explain ipaddresspools.metallb.io

cat <<EOF | kubectl apply -f -

apiVersion: metallb.io/v1beta1

kind: IPAddressPool

metadata:

name: my-ippool

namespace: metallb-system

spec:

addresses:

- 172.18.255.200-172.18.255.250

EOF

kubectl get ipaddresspools -n metallb-system

NAME AUTO ASSIGN AVOID BUGGY IPS ADDRESSES

my-ippool true false ["172.18.255.200-172.18.255.250"]

# L2Advertisement 생성 : 설정한 IPpool을 기반으로 Layer2 모드로 LoadBalancer IP 사용 허용

## Kubernetes 클러스터 내의 서비스가 외부 네트워크에 IP 주소를 광고하는 방식을 정의

kubectl explain l2advertisements.metallb.io

cat <<EOF | kubectl apply -f -

apiVersion: metallb.io/v1beta1

kind: L2Advertisement

metadata:

name: my-l2-advertise

namespace: metallb-system

spec:

ipAddressPools:

- my-ippool

EOF

kubectl get l2advertisements -n metallb-system

NAME IPADDRESSPOOLS IPADDRESSPOOL SELECTORS INTERFACES

my-l2-advertise ["my-ippool"]

# (옵션) metallb-speaker 파드 로그 확인

kubectl logs -n metallb-system -l app=metallb -f

kubectl logs -n metallb-system -l component=speaker --since 1h

kubectl logs -n metallb-system -l component=speaker -f

# (옵션) kubectl krew 플러그인 stern 설치 후 아래 명령 사용 가능

kubectl stern -n metallb-system -l app=metallb

kubectl stern -n metallb-system -l component=speaker --since 1h

kubectl stern -n metallb-system -l component=speaker # 기본 설정이 follow

kubectl stern -n metallb-system speaker # 매칭 사용 가능

서비스 및 리더 파드를 확인해보면 위에서 선언한 IP 풀 대역으로 서비스들이 할당된 것을 확인할 수 있으며, NodePort를 할당한 것을 확인할 수 있습니다. 또한 ARP scan 정보에 External IP가 표출됩니다.

# arp scan 해두기

docker exec -it myk8s-control-plane arp-scan --interfac=eth0 --localnet

# LoadBalancer 타입의 서비스 생성 확인 : EXTERNAL-IP가 서비스 마다 할당되며, 실습 환경에 따라 다를 수 있음

## LoadBalancer 타입의 서비스는 NodePort 와 ClusterIP 를 포함함 - 'allocateLoadBalancerNodePorts : true' 기본값

## ExternalIP 로 접속 시 사용하는 포트는 PORT(S) 의 앞에 있는 값을 사용 (아래의 경우는 TCP 80 임)

## 만약 노드의 IP에 NodePort 로 접속 시 사용하는 포트는 PORT(S) 의 뒤에 있는 값을 사용 (아래는 30485 임)

kubectl get service,ep

NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE

service/kubernetes ClusterIP 10.200.1.1 <none> 443/TCP 121m

service/svc1 LoadBalancer 10.200.1.69 172.18.255.200 80:30485/TCP 3m37s

service/svc2 LoadBalancer 10.200.1.218 172.18.255.201 80:31046/TCP 3m37s

service/svc3 LoadBalancer 10.200.1.81 172.18.255.202 80:30459/TCP 3m37s

NAME ENDPOINTS AGE

endpoints/kubernetes 172.18.0.5:6443 31m

endpoints/svc1 10.10.1.6:80,10.10.3.6:80 8m4s

endpoints/svc2 10.10.1.6:80,10.10.3.6:80 8m4s

endpoints/svc3 10.10.1.6:80,10.10.3.6:80 8m4s

# LoadBalancer 타입은 기본적으로 NodePort를 포함 사용. NodePort는 ClusterIP를 포함 사용.

## 클라우드사업자 LB Type이나 온프레미스환경 HW LB Type 경우 LB 사용 시 NodePort 미사용 설정 가능

kubectl describe svc svc1

## 아래 처럼 LB VIP 별로 이던 speaker 배포된 노드가 리더 역할을 하는지 확인 가능

kubectl describe svc | grep Events: -A5

...

Events:

Type Reason Age From Message

---- ------ ---- ---- -------

Normal IPAllocated 40m metallb-controller Assigned IP ["172.18.255.201"]

Normal nodeAssigned 40m metallb-speaker announcing from node "myk8s-worker" with protocol "layer2"

...

kubectl get svc svc1 -o json | jq

...

"spec": {

"allocateLoadBalancerNodePorts": true,

...

"status": {

"loadBalancer": {

"ingress": [

{

"ip": "172.18.255.202",

"ipMode": "VIP" # https://kubernetes.io/blog/2023/12/18/kubernetes-1-29-feature-loadbalancer-ip-mode-alpha/

} # https://kubernetes.io/docs/concepts/services-networking/service/#load-balancer-ip-mode

# metallb CRD인 servicel2status 로 상태 정보 확인

kubectl explain servicel2status

kubectl get servicel2status -n metallb-system

kubectl describe servicel2status -n metallb-system

kubectl get servicel2status -n metallb-system -o json --watch # watch 모드

다음으로 EXTERNAL-IP를 통해 통신이 잘 되는지와, Metal LB 스피커가 어디에서 동작하고 있는지 확인해 봅니다.

# 현재 SVC EXTERNAL-IP를 변수에 지정

SVC1EXIP=$(kubectl get svc svc1 -o jsonpath='{.status.loadBalancer.ingress[0].ip}')

SVC2EXIP=$(kubectl get svc svc2 -o jsonpath='{.status.loadBalancer.ingress[0].ip}')

SVC3EXIP=$(kubectl get svc svc3 -o jsonpath='{.status.loadBalancer.ingress[0].ip}')

echo $SVC1EXIP $SVC2EXIP $SVC3EXIP

# mypc/mypc2 에서 현재 SVC EXTERNAL-IP를 담당하는 리더 Speaker 파드 찾는법 : arping 툴 사용

## Unicast reply from 172.18.255.200: 해당 IP 주소에서 응답을 받았음을 의미합니다.

## Sent 1 probes (1 broadcast(s)): 하나의 ARP 요청을 보냈고, 브로드캐스트 방식으로 요청을 전송했음을 나타냅니다.

## Received 1 response(s): 하나의 응답을 수신했음을 나타냅니다.

docker exec -it mypc arping -I eth0 -f -c 1 $SVC1EXIP

docker exec -it mypc arping -I eth0 -f -c 1 $SVC2EXIP

docker exec -it mypc arping -I eth0 -f -c 1 $SVC3EXIP

for i in $SVC1EXIP $SVC2EXIP $SVC3EXIP; do docker exec -it mypc arping -I eth0 -f -c 1 $i; done

docker exec -it mypc ip -c neigh

docker exec -it mypc ping -c 1 -w 1 -W 1 $SVC1EXIP

docker exec -it mypc ping -c 1 -w 1 -W 1 $SVC2EXIP

docker exec -it mypc ping -c 1 -w 1 -W 1 $SVC3EXIP

for i in $SVC1EXIP $SVC2EXIP $SVC3EXIP; do docker exec -it mypc ping -c 1 -w 1 -W 1 $i; done

for i in 172.18.0.2 172.18.0.3 172.18.0.4 172.18.0.5; do docker exec -it mypc ping -c 1 -w 1 -W 1 $i; done

# mypc/mypc2 에서 arp 테이블 정보 확인 >> SVC IP별로 리더 파드(스피커) 역할의 노드를 확인!

docker exec -it mypc ip -c neigh | sort

172.18.0.2 dev eth0 lladdr 02:42:ac:12:00:02 REACHABLE

172.18.0.3 dev eth0 lladdr 02:42:ac:12:00:03 REACHABLE

172.18.0.4 dev eth0 lladdr 02:42:ac:12:00:04 REACHABLE

172.18.0.5 dev eth0 lladdr 02:42:ac:12:00:05 DELAY

172.18.255.200 dev eth0 lladdr 02:42:ac:12:00:04 STALE

172.18.255.201 dev eth0 lladdr 02:42:ac:12:00:04 STALE

172.18.255.202 dev eth0 lladdr 02:42:ac:12:00:02 STALE

kubectl get node -owide # mac 주소에 매칭되는 IP(노드) 찾기

# (옵션) 노드에서 ARP 패킷 캡쳐 확인

docker exec -it myk8s-control-plane tcpdump -i eth0 -nn arp

docker exec -it myk8s-worker tcpdump -i eth0 -nn arp

docker exec -it myk8s-worker2 tcpdump -i eth0 -nn arp

docker exec -it myk8s-worker3 tcpdump -i eth0 -nn arp

# (옵션) metallb-speaker 파드 로그 확인

kubectl logs -n metallb-system -l app=metallb -f

kubectl logs -n metallb-system -l component=speaker --since 1h

kubectl logs -n metallb-system -l component=speaker -f

# (옵션) kubectl krew 플러그인 stern 설치 후 아래 명령 사용 가능

kubectl stern -n metallb-system -l app=metallb

kubectl stern -n metallb-system -l component=speaker --since 1h

kubectl stern -n metallb-system -l component=speaker # 기본 설정이 follow

kubectl stern -n metallb-system speaker # 매칭 사용 가능

마지막으로 접속 테스트 및 부하분산 테스트를 수행해 봅니다.

# 현재 SVC EXTERNAL-IP를 변수에 지정

SVC1EXIP=$(kubectl get svc svc1 -o jsonpath='{.status.loadBalancer.ingress[0].ip}')

SVC2EXIP=$(kubectl get svc svc2 -o jsonpath='{.status.loadBalancer.ingress[0].ip}')

SVC3EXIP=$(kubectl get svc svc3 -o jsonpath='{.status.loadBalancer.ingress[0].ip}')

echo $SVC1EXIP $SVC2EXIP $SVC3EXIP

# mypc/mypc2 에서 접속 테스트

docker exec -it mypc curl -s $SVC1EXIP

docker exec -it mypc curl -s $SVC1EXIP | grep Hostname

for i in $SVC1EXIP $SVC2EXIP $SVC3EXIP; do docker exec -it mypc curl -s $i | grep Hostname ; done

for i in $SVC1EXIP $SVC2EXIP $SVC3EXIP; do echo ">> Access Service External-IP : $i <<" ; docker exec -it mypc curl -s $i | grep Hostname ; echo ; done

## RemoteAddr 주소는 어떻게 나오나요? 왜 그럴까요?

## NodePort 기본 동작과 동일하게 인입한 노드의 인터페이스로 SNAT 되어서 최종 파드로 전달됨

for i in $SVC1EXIP $SVC2EXIP $SVC3EXIP; do echo ">> Access Service External-IP : $i <<" ;docker exec -it mypc curl -s $i | egrep 'Hostname|RemoteAddr|Host:' ; echo ; done

# 부하분산 접속됨

docker exec -it mypc zsh -c "for i in {1..100}; do curl -s $SVC1EXIP | grep Hostname; done | sort | uniq -c | sort -nr"

docker exec -it mypc zsh -c "for i in {1..100}; do curl -s $SVC2EXIP | grep Hostname; done | sort | uniq -c | sort -nr"

docker exec -it mypc zsh -c "for i in {1..100}; do curl -s $SVC3EXIP | grep Hostname; done | sort | uniq -c | sort -nr"

# 지속적으로 반복 접속

docker exec -it mypc zsh -c "while true; do curl -s --connect-timeout 1 $SVC1EXIP | egrep 'Hostname|RemoteAddr'; date '+%Y-%m-%d %H:%M:%S' ; echo ; sleep 1; done"

docker exec -it mypc zsh -c "while true; do curl -s --connect-timeout 1 $SVC2EXIP | egrep 'Hostname|RemoteAddr'; date '+%Y-%m-%d %H:%M:%S' ; echo ; sleep 1; done"

docker exec -it mypc zsh -c "while true; do curl -s --connect-timeout 1 $SVC3EXIP | egrep 'Hostname|RemoteAddr'; date '+%Y-%m-%d %H:%M:%S' ; echo ; sleep 1; done"

# LoadBalancer Type은 기본값으로 NodePort 포함. NodePort 서비스는 ClusterIP 를 포함

# NodePort:PORT 및 CLUSTER-IP:PORT 로 접속 가능!

kubectl get svc svc1

NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE

svc1 LoadBalancer 10.200.1.82 172.18.255.202 80:30246/TCP 49m

# 컨트롤노드에서 각각 접속 확인 실행 해보자

docker exec -it myk8s-control-plane curl -s 127.0.0.0:30246 # NodePor Type

docker exec -it myk8s-control-plane curl -s 10.200.1.82 # ClusterIP Tpye

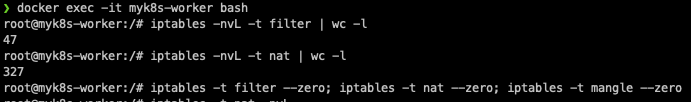

iptables 정책 확인

LoadBalancer 서비스 관련 라우팅 흐름은 다음과 같습니다.

1번, 2번 과정은 지난 스터디에서 확인한 ClusterIP, NodePort와 동일합니다. KUBE-SERVICES에서 ExternalIP 마다 KUBE-FW-XXX 체인으로 점프를 합니다.

3번 KUBE-FW-XXX 체인 규칙은 KUBE-MARK-MASQ와 KUBE-SVC-YYY 체인으로 전달 됩니다. KUBE-MARK-MSQ체인에서 Mark를 하고 추후 6번 과정에서 클라이언트의 출발지 IP를 SNAT 마스커레이딩 처리를 하게 됩니다.

4번 KUBE-SVC-YYY 체인 규칙 역시 이전과 동일합니다. 서비스에 연동된 파드로 5번 2개의 SEP 규칙이 있고 랜덤으로 부하분산하여 연결됩니다.

6번 마지막으로 KUBE-POSTROUTING 규칙에서는 Mark되어있는지를 확인하고, Mark되어 있을 경우 출발지 IP를 SNAT 마스커레이딩 처리를 하게 됩니다.

정리하자면 MetalLB Layer2모드는 ExternalIP에 대한 소유자가 있는 노드가 서비스 트래픽을 처리하며, 해당 노드에 IPTABLES 규칙에 의해서 각 노드에 있는 파드로 랜덤 부하분산 접속 됩니다.

앞서 설명한 내용을 실습을 통해서 확인해 봅니다.

# 현재 SVC EXTERNAL-IP를 변수에 지정

SVC1EXIP=$(kubectl get svc svc1 -o jsonpath='{.status.loadBalancer.ingress[0].ip}')

SVC2EXIP=$(kubectl get svc svc2 -o jsonpath='{.status.loadBalancer.ingress[0].ip}')

SVC3EXIP=$(kubectl get svc svc3 -o jsonpath='{.status.loadBalancer.ingress[0].ip}')

echo $SVC1EXIP $SVC2EXIP $SVC3EXIP

# 부하분산 접속됨

docker exec -it mypc zsh -c "for i in {1..100}; do curl -s $SVC1EXIP | grep Hostname; done | sort | uniq -c | sort -nr"

docker exec -it mypc zsh -c "for i in {1..100}; do curl -s $SVC2EXIP | grep Hostname; done | sort | uniq -c | sort -nr"

docker exec -it mypc zsh -c "for i in {1..100}; do curl -s $SVC3EXIP | grep Hostname; done | sort | uniq -c | sort -nr"

# 지속적으로 반복 접속

docker exec -it mypc zsh -c "while true; do curl -s --connect-timeout 1 $SVC1EXIP | egrep 'Hostname|RemoteAddr'; date '+%Y-%m-%d %H:%M:%S' ; echo ; sleep 1; done"

docker exec -it mypc zsh -c "while true; do curl -s --connect-timeout 1 $SVC2EXIP | egrep 'Hostname|RemoteAddr'; date '+%Y-%m-%d %H:%M:%S' ; echo ; sleep 1; done"

docker exec -it mypc zsh -c "while true; do curl -s --connect-timeout 1 $SVC3EXIP | egrep 'Hostname|RemoteAddr'; date '+%Y-%m-%d %H:%M:%S' ; echo ; sleep 1; done"

# 컨트롤플레인에서 확인 : 너무 복잡해서 리턴 트래픽에 대해서는 상세히 분석 정리하지 않습니다.

docker exec -it myk8s-worker bash

----------------------------------------

# iptables 확인

iptables -t filter -S

iptables -t nat -S

iptables -t nat -S | wc -l

iptables -t mangle -S

# iptables 상세 확인 - 매칭 패킷 카운트, 인터페이스 정보 등 포함

iptables -nvL -t filter

iptables -nvL -t nat

iptables -nvL -t mangle

# rule 갯수 확인

iptables -nvL -t filter | wc -l

iptables -nvL -t nat | wc -l

# 규칙 패킷 바이트 카운트 초기화

iptables -t filter --zero; iptables -t nat --zero; iptables -t mangle --zero

# 정책 확인 : 아래 정책 내용은 핵심적인 룰(rule)만 표시했습니다!

iptables -t nat -nvL

iptables -t nat -S

PREROUTING

# SVC1(External-IP) 접속 시 iptables 에서 DNAT 되어 파드로 전달된다 (SNAT 도 동작)

iptables -t nat -S PREROUTING

-A PREROUTING -m comment --comment "kubernetes service portals" -j KUBE-SERVICES

iptables -t nat -S KUBE-SERVICES

SVC1EXIP=<직접입력>

SVC1EXIP=172.18.255.202

iptables -t nat -S KUBE-SERVICES |grep $SVC1EXIP

-A KUBE-SERVICES -d 172.18.255.202/32 -p tcp -m comment --comment "default/svc1:svc1-webport loadbalancer IP" -m tcp --dport 80 -j KUBE-EXT-DLGPAL4ZCYSJ7UPR

iptables -t nat -S KUBE-EXT-DLGPAL4ZCYSJ7UPR

-A KUBE-EXT-DLGPAL4ZCYSJ7UPR -m comment --comment "masquerade traffic for default/svc1:svc1-webport external destinations" -j KUBE-MARK-MASQ

-A KUBE-EXT-DLGPAL4ZCYSJ7UPR -j KUBE-SVC-DLGPAL4ZCYSJ7UPR

iptables -t nat -S KUBE-MARK-MASQ

-A KUBE-MARK-MASQ -j MARK --set-xmark 0x4000/0x4000

iptables -t nat -S KUBE-SVC-DLGPAL4ZCYSJ7UPR

-A KUBE-SVC-DLGPAL4ZCYSJ7UPR ! -s 10.10.0.0/16 -d 10.200.1.82/32 -p tcp -m comment --comment "default/svc1:svc1-webport cluster IP" -m tcp --dport 80 -j KUBE-MARK-MASQ

-A KUBE-SVC-DLGPAL4ZCYSJ7UPR -m comment --comment "default/svc1:svc1-webport -> 10.10.1.6:80" -m statistic --mode random --probability 0.50000000000 -j KUBE-SEP-USUIKZUHVJLOFB4D

-A KUBE-SVC-DLGPAL4ZCYSJ7UPR -m comment --comment "default/svc1:svc1-webport -> 10.10.3.6:80" -j KUBE-SEP-SXKPWGGXEDMXXU4H

#

iptables -t nat -S KUBE-SEP-USUIKZUHVJLOFB4D

-A KUBE-SEP-USUIKZUHVJLOFB4D -s 10.10.1.6/32 -m comment --comment "default/svc1:svc1-webport" -j KUBE-MARK-MASQ

-A KUBE-SEP-USUIKZUHVJLOFB4D -p tcp -m comment --comment "default/svc1:svc1-webport" -m tcp -j DNAT --to-destination 10.10.1.6:80

iptables -t nat -S KUBE-SEP-SXKPWGGXEDMXXU4H

-A KUBE-SEP-SXKPWGGXEDMXXU4H -s 10.10.3.6/32 -m comment --comment "default/svc1:svc1-webport" -j KUBE-MARK-MASQ

-A KUBE-SEP-SXKPWGGXEDMXXU4H -p tcp -m comment --comment "default/svc1:svc1-webport" -m tcp -j DNAT --to-destination 10.10.3.6:80

POSTROUTING

iptables -t nat -S POSTROUTING

iptables -t nat -S KUBE-POSTROUTING

-A KUBE-POSTROUTING -m mark ! --mark 0x4000/0x4000 -j RETURN

-A KUBE-POSTROUTING -j MARK --set-xmark 0x4000/0x0

-A KUBE-POSTROUTING -m comment --comment "kubernetes service traffic requiring SNAT" -j MASQUERADE --random-fully

# SVC2(External-IP) 접속 시 iptables 에서 DNAT 되어 파드로 전달된다 (SNAT 도 동작) : 위와 상동!

# SVC3(External-IP) 접속 시 iptables 에서 DNAT 되어 파드로 전달된다 (SNAT 도 동작) : 위와 상동!

MetalLB -Failover 테스트

장애 발생전 워커노드 1에는 스피커 파드가 SVC1, SVC3의 리더 스피커 파드가 있는 상태입니다. 장애가 발생하게 되면 다른 스피커 파드들이 워커노드1의 장애를 인지하게 됩니다.

이후 장애가 발생한 스피커파드가 소유한 서비스의 ExternalIP에 대한 리더 파드를 다시 선출하게 됩니다.

이 복구과정은 10초~1분 정도가 소유하게 됩니다.

# 사전 준비

## 지속적으로 반복 접속

SVC1EXIP=$(kubectl get svc svc1 -o jsonpath='{.status.loadBalancer.ingress[0].ip}')

docker exec -it mypc zsh -c "while true; do curl -s --connect-timeout 1 $SVC1EXIP | egrep 'Hostname|RemoteAddr'; date '+%Y-%m-%d %H:%M:%S' ; echo ; sleep 1; done"

## 상태 모니터링

watch -d kubectl get pod,svc,ep

## 실시간 로그 확인

kubectl logs -n metallb-system -l app=metallb -f

혹은

kubectl stern -n metallb-system -l app=metallb

# 장애 재연

## 리더 Speaker 파드가 존재하는 노드(실제는 컨테이너)를 중지

docker stop <svc1 번 리더 Speaker 파드가 존재하는 노드(실제는 컨테이너)> --signal 9

docker stop myk8s-worker --signal 9

혹은

docker stop <svc1 번 리더 Speaker 파드가 존재하는 노드(실제는 컨테이너)> --signal 15

docker stop myk8s-worker --signal 15

docker ps -a

docker ps -a | grep worker$

## 지속적으로 반복 접속 상태 모니터링

### curl 연속 접속 시도 >> 대략 10초 이내에 정상 접근 되었지만, 20초까지는 불안정하게 접속이 되었다

### 실제로는 다른 노드의 speaker 파드가 리더가 되고, 이후 다시 노드(컨테이너)가 정상화되면, 다시 리더 speaker 가 됨

docker exec -it mypc zsh -c "while true; do curl -s --connect-timeout 1 $SVC1EXIP | egrep 'Hostname|RemoteAddr'; date '+%Y-%m-%d %H:%M:%S' ; echo ; sleep 1; done"

Hostname: webpod1

RemoteAddr: 172.18.0.2:25432

2024-09-29 06:31:07

2024-09-29 06:31:09

Hostname: webpod2

RemoteAddr: 172.18.0.2:26011

2024-09-29 06:31:10

2024-09-29 06:31:12

2024-09-29 06:31:14

...

# 변경된 리더 Speaker 파드 확인

# mypc/mypc2 에서 현재 SVC EXTERNAL-IP를 담당하는 리더 Speaker 파드 찾기

for i in $SVC1EXIP $SVC2EXIP $SVC3EXIP; do docker exec -it mypc ping -c 1 -w 1 -W 1 $i; done

# mypc/mypc2 에서 arp 테이블 정보 확인 >> SVC IP별로 리더 파드(스피커) 역할의 노드를 확인!

docker exec -it mypc ip -c neigh | sort

kubectl get node -owide # mac 주소에 매칭되는 IP(노드) 찾기

# 장애 원복(노드 정상화)

## 노드(실제 컨테이너) 정상화

docker start <svc1 번 리더 Speaker 파드가 존재하는 노드(실제는 컨테이너)>

docker start myk8s-worker

# 변경된 리더 Speaker 파드 확인

# mypc/mypc2 에서 현재 SVC EXTERNAL-IP를 담당하는 리더 Speaker 파드 찾기

for i in $SVC1EXIP $SVC2EXIP $SVC3EXIP; do docker exec -it mypc ping -c 1 -w 1 -W 1 $i; done

# mypc/mypc2 에서 arp 테이블 정보 확인 >> SVC IP별로 리더 파드(스피커) 역할의 노드를 확인!

docker exec -it mypc ip -c neigh | sort

kubectl get node -owide # mac 주소에 매칭되는 IP(노드) 찾기

먼저 기존의 SVC들의 이벤트와 External IP를 확인합니다.

제 환경에서는 1번 2번 서비스가 WorkerNode 1에 할당되어 있습니다.

워커노드가 죽게되면 다음과 같이 통신 장애가 발생하게 됩니다.

하지만 잠시 시간이 지나면 다시 통신이 잘 됩니다.

장애가 발생하면 다른 노드로 리더 스피커 파드가 변경됩니다.

만약 노드 장애가 복구되면 원래의 노드로 리더스피커 파드가 변경됩니다.

스터디에서 언급한 대로 장애 복구에 소요되는 시간이 꽤 길었던 것을 확인할 수 있었습니다.

기타

ExternalIP 서비스

ExternalIP 서비스는 특정 노드 IP(포트)로 인입한 트래픽을 컨테이너로 보내서 외부에서 접속할 수 있도록 지원합니다.

다음과 같이 특정 노드 주소와 목적지 컨테이너 포트를 직접 세팅할 수 있습니다.

apiVersion: v1

kind: Service

metadata:

name: svc-externalip

spec:

type: ClusterIP

externalIPs:

- 192.168.10.101

- 192.168.10.102

IPVS Proxy 모드

출처: CloudNet@ 스터디 - 가시다님

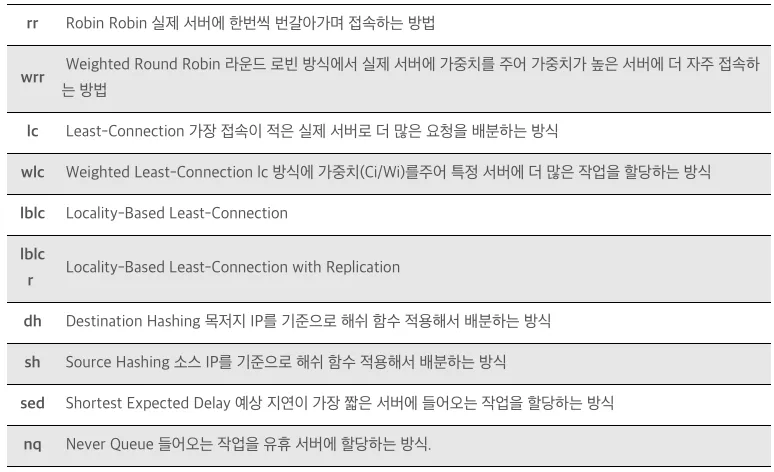

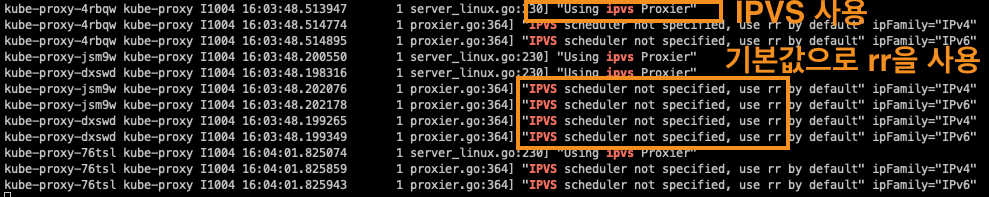

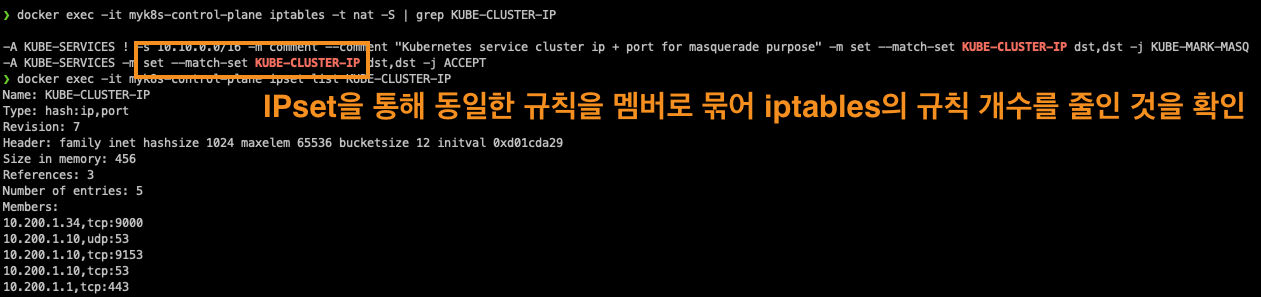

IPVS proxy 모드는 3가지 모드 중 가장 성능 효율적인 모드입니다. IPVS는 커널에서 동작하는 소프트웨어 로드밸런서로써, 넷필터를 사용하여 TCP/UDP 요청을 처리할 수 있습니다. 또한 다양한 부하분산 알고리즘을 제공하며, iptable의 규칙 갯수를 줄이는 등을 통해 높은 처리 성능을 보여주는 모드입니다.

IPVS proxy 모드는 IPVS가 Service Proxy역할을 수행하는 모드라고 할 수 있습니다.

아래는 다른 블로그에서 발췌한 부하분산 스케줄링 표입니다.

IPVS Proxy 환경 셋팅

# 파일 작성

cat <<EOT> kind-svc-2w-ipvs.yaml

kind: Cluster

apiVersion: kind.x-k8s.io/v1alpha4

featureGates:

"InPlacePodVerticalScaling": true

"MultiCIDRServiceAllocator": true

nodes:

- role: control-plane

labels:

mynode: control-plane

topology.kubernetes.io/zone: ap-northeast-2a

extraPortMappings:

- containerPort: 30000

hostPort: 30000

- containerPort: 30001

hostPort: 30001

- containerPort: 30002

hostPort: 30002

- containerPort: 30003

hostPort: 30003

- containerPort: 30004

hostPort: 30004

kubeadmConfigPatches:

- |

kind: ClusterConfiguration

apiServer:

extraArgs:

runtime-config: api/all=true

controllerManager:

extraArgs:

bind-address: 0.0.0.0

etcd:

local:

extraArgs:

listen-metrics-urls: http://0.0.0.0:2381

scheduler:

extraArgs:

bind-address: 0.0.0.0

- |

kind: KubeProxyConfiguration

metricsBindAddress: 0.0.0.0

ipvs:

strictARP: true

- role: worker

labels:

mynode: worker1

topology.kubernetes.io/zone: ap-northeast-2a

- role: worker

labels:

mynode: worker2

topology.kubernetes.io/zone: ap-northeast-2b

- role: worker

labels:

mynode: worker3

topology.kubernetes.io/zone: ap-northeast-2c

networking:

podSubnet: 10.10.0.0/16

serviceSubnet: 10.200.1.0/24

kubeProxyMode: "ipvs"

EOT

# k8s 클러스터 설치

kind create cluster --config kind-svc-2w-ipvs.yaml --name myk8s --image kindest/node:v1.31.0

docker ps

# 노드에 기본 툴 설치

docker exec -it myk8s-control-plane sh -c 'apt update && apt install tree psmisc lsof wget bsdmainutils bridge-utils net-tools dnsutils ipset ipvsadm nfacct tcpdump ngrep iputils-ping arping git vim arp-scan -y'

for i in worker worker2 worker3; do echo ">> node myk8s-$i <<"; docker exec -it myk8s-$i sh -c 'apt update && apt install tree psmisc lsof wget bsdmainutils bridge-utils net-tools dnsutils ipset ipvsadm nfacct tcpdump ngrep iputils-ping arping -y'; echo; done

# kube-proxy configmap 확인

kubectl describe cm -n kube-system kube-proxy

...

mode: ipvs

ipvs: # 아래 각각 옵션 의미 조사해보자!

excludeCIDRs: null

minSyncPeriod: 0s

scheduler: ""

strictARP: true # MetalLB 동작을 위해서 true 설정 변경 필요

syncPeriod: 0s

tcpFinTimeout: 0s

tcpTimeout: 0s

udpTimeout: 0s

...

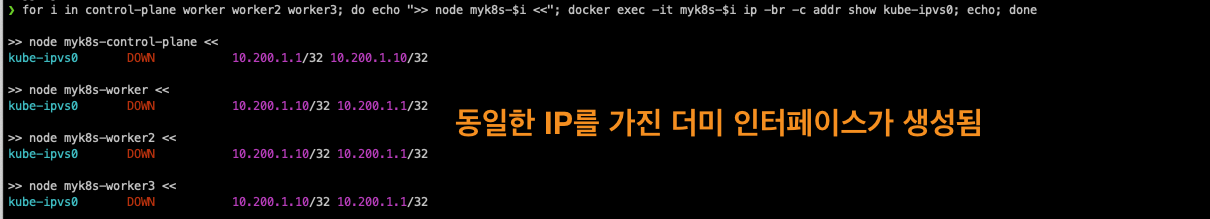

# strictARP: true는 ARP 패킷을 보다 엄격하게 처리하겠다는 설정입니다.

## IPVS 모드에서 strict ARP가 활성화되면, 노드의 인터페이스는 자신에게 할당된 IP 주소에 대해서만 ARP 응답을 보내게 됩니다.

## 이는 IPVS로 로드밸런싱할 때 ARP 패킷이 잘못된 인터페이스로 전달되는 문제를 방지합니다.

## 이 설정은 특히 클러스터 내에서 여러 노드가 동일한 IP를 갖는 VIP(Virtual IP)를 사용하는 경우 중요합니다.

# 노드 별 네트워트 정보 확인 : kube-ipvs0 네트워크 인터페이스 확인

for i in control-plane worker worker2 worker3; do echo ">> node myk8s-$i <<"; docker exec -it myk8s-$i ip -c route; echo; done

for i in control-plane worker worker2 worker3; do echo ">> node myk8s-$i <<"; docker exec -it myk8s-$i ip -c addr; echo; done

for i in control-plane worker worker2 worker3; do echo ">> node myk8s-$i <<"; docker exec -it myk8s-$i ip -br -c addr show kube-ipvs0; echo; done

>> node myk8s-control-plane <<

kube-ipvs0 DOWN 10.200.1.1/32 10.200.1.10/32

>> node myk8s-worker <<

kube-ipvs0 DOWN 10.200.1.10/32 10.200.1.1/32

>> node myk8s-worker2 <<

kube-ipvs0 DOWN 10.200.1.1/32 10.200.1.10/32

>> node myk8s-worker3 <<

kube-ipvs0 DOWN 10.200.1.10/32 10.200.1.1/32

for i in control-plane worker worker2 worker3; do echo ">> node myk8s-$i <<"; docker exec -it myk8s-$i ip -d -c addr show kube-ipvs0; echo; done

>> node myk8s-control-plane <<

11: kube-ipvs0: <BROADCAST,NOARP> mtu 1500 qdisc noop state DOWN group default

link/ether 9e:1d:ca:21:c6:d1 brd ff:ff:ff:ff:ff:ff promiscuity 0 allmulti 0 minmtu 0 maxmtu 0

dummy numtxqueues 1 numrxqueues 1 gso_max_size 65536 gso_max_segs 65535 tso_max_size 65536 tso_max_segs 65535 gro_max_size 65536

inet 10.200.1.10/32 scope global kube-ipvs0

valid_lft forever preferred_lft forever

inet 10.200.1.1/32 scope global kube-ipvs0

valid_lft forever preferred_lft forever

>> node myk8s-worker <<

11: kube-ipvs0: <BROADCAST,NOARP> mtu 1500 qdisc noop state DOWN group default

link/ether fa:21:0a:00:a7:6c brd ff:ff:ff:ff:ff:ff promiscuity 0 allmulti 0 minmtu 0 maxmtu 0

dummy numtxqueues 1 numrxqueues 1 gso_max_size 65536 gso_max_segs 65535 tso_max_size 65536 tso_max_segs 65535 gro_max_size 65536

inet 10.200.1.1/32 scope global kube-ipvs0

valid_lft forever preferred_lft forever

inet 10.200.1.10/32 scope global kube-ipvs0

valid_lft forever preferred_lft forever

>> node myk8s-worker2 <<

11: kube-ipvs0: <BROADCAST,NOARP> mtu 1500 qdisc noop state DOWN group default

link/ether ba:e9:75:56:db:00 brd ff:ff:ff:ff:ff:ff promiscuity 0 allmulti 0 minmtu 0 maxmtu 0

dummy numtxqueues 1 numrxqueues 1 gso_max_size 65536 gso_max_segs 65535 tso_max_size 65536 tso_max_segs 65535 gro_max_size 65536

inet 10.200.1.10/32 scope global kube-ipvs0

valid_lft forever preferred_lft forever

inet 10.200.1.1/32 scope global kube-ipvs0

valid_lft forever preferred_lft forever

>> node myk8s-worker3 <<

11: kube-ipvs0: <BROADCAST,NOARP> mtu 1500 qdisc noop state DOWN group default

link/ether a2:1d:9c:e6:ad:84 brd ff:ff:ff:ff:ff:ff promiscuity 0 allmulti 0 minmtu 0 maxmtu 0

dummy numtxqueues 1 numrxqueues 1 gso_max_size 65536 gso_max_segs 65535 tso_max_size 65536 tso_max_segs 65535 gro_max_size 65536

inet 10.200.1.1/32 scope global kube-ipvs0

valid_lft forever preferred_lft forever

inet 10.200.1.10/32 scope global kube-ipvs0

valid_lft forever preferred_lft forever

# kube-ipvs0 에 할당된 IP(기본 IP + 보조 IP들) 정보 확인

kubectl get svc,ep -A

NAMESPACE NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE

default kubernetes ClusterIP 10.200.1.1 <none> 443/TCP 3m8s

kube-system kube-dns ClusterIP 10.200.1.10 <none> 53/UDP,53/TCP,9153/TCP 3m7s

# ipvsadm 툴로 부하분산 되는 정보 확인 : 서비스의 IP와 서비스에 연동되어 있는 파드의 IP 를 확인

## Service IP(VIP) 처리를 ipvs 에서 담당 -> 이를 통해 iptables 에 체인/정책이 상당 수준 줄어듬

for i in control-plane worker worker2 worker3; do echo ">> node myk8s-$i <<"; docker exec -it myk8s-$i ipvsadm -Ln ; echo; done

## IPSET 확인

docker exec -it myk8s-worker ipset -h

docker exec -it myk8s-worker ipset -L

# iptables 정보 확인 : 정책 갯수를 iptables proxy 모드와 비교해보자

for i in filter nat mangle raw ; do echo ">> IPTables Type : $i <<"; docker exec -it myk8s-control-plane iptables -t $i -S ; echo; done

for i in filter nat mangle raw ; do echo ">> IPTables Type : $i <<"; docker exec -it myk8s-worker iptables -t $i -S ; echo; done

for i in filter nat mangle raw ; do echo ">> IPTables Type : $i <<"; docker exec -it myk8s-worker2 iptables -t $i -S ; echo; done

for i in filter nat mangle raw ; do echo ">> IPTables Type : $i <<"; docker exec -it myk8s-worker3 iptables -t $i -S ; echo; done

# 각 노드 bash 접속

docker exec -it myk8s-control-plane bash

docker exec -it myk8s-worker bash

docker exec -it myk8s-worker2 bash

docker exec -it myk8s-worker3 bash

----------------------------------------

exit

----------------------------------------

# mypc 컨테이너 기동 : kind 도커 브리지를 사용하고, 컨테이너 IP를 직접 지정 혹은 IP 지정 없이 배포

docker run -d --rm --name mypc --network kind --ip 172.18.0.100 nicolaka/netshoot sleep infinity

혹은

docker run -d --rm --name mypc --network kind nicolaka/netshoot sleep infinity

docker ps

IPVS 모드로 로드밸런싱 테스트를 수행할 오브젝트들을 생성합니다.

# 목적지 Pod 생성

cat <<EOT> 3pod.yaml

apiVersion: v1

kind: Pod

metadata:

name: webpod1

labels:

app: webpod

spec:

nodeName: myk8s-worker

containers:

- name: container

image: traefik/whoami

terminationGracePeriodSeconds: 0

---

apiVersion: v1

kind: Pod

metadata:

name: webpod2

labels:

app: webpod

spec:

nodeName: myk8s-worker2

containers:

- name: container

image: traefik/whoami

terminationGracePeriodSeconds: 0

---

apiVersion: v1

kind: Pod

metadata:

name: webpod3

labels:

app: webpod

spec:

nodeName: myk8s-worker3

containers:

- name: container

image: traefik/whoami

terminationGracePeriodSeconds: 0

EOT

#클라이언트 Pod 생성

cat <<EOT> netpod.yaml

apiVersion: v1

kind: Pod

metadata:

name: net-pod

spec:

nodeName: myk8s-control-plane

containers:

- name: netshoot-pod

image: nicolaka/netshoot

command: ["tail"]

args: ["-f", "/dev/null"]

terminationGracePeriodSeconds: 0

EOT

#ClusterIP 서비스 생성

cat <<EOT> svc-clusterip.yaml

apiVersion: v1

kind: Service

metadata:

name: svc-clusterip

spec:

ports:

- name: svc-webport

port: 9000 # 서비스 IP 에 접속 시 사용하는 포트 port 를 의미

targetPort: 80 # 타킷 targetPort 는 서비스를 통해서 목적지 파드로 접속 시 해당 파드로 접속하는 포트를 의미

selector:

app: webpod # 셀렉터 아래 app:webpod 레이블이 설정되어 있는 파드들은 해당 서비스에 연동됨

type: ClusterIP # 서비스 타입

EOT

# 생성

kubectl apply -f 3pod.yaml,netpod.yaml,svc-clusterip.yaml

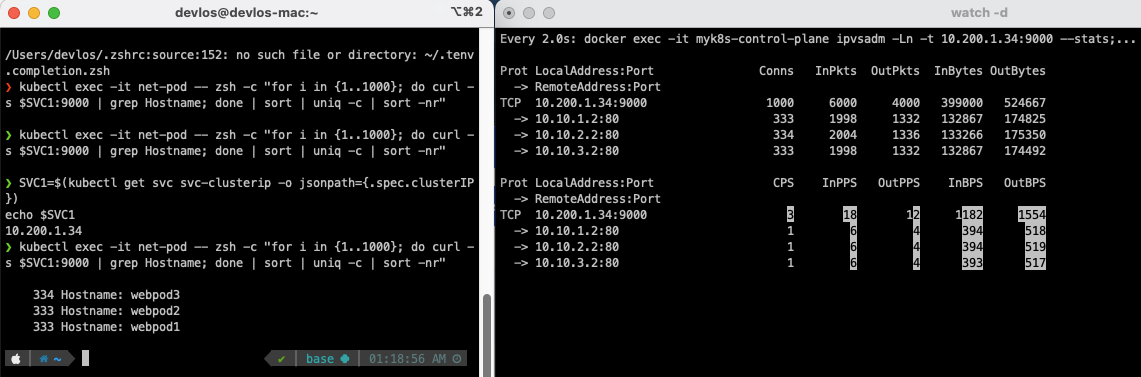

다음으로 IPVS모드가 적용된 것을 확인합니다.

부하분산이 잘 되는 것을 확인할 수 있습니다.

LoxiLB 소개

클라우드 네이티브 로드밸런서라고도 불리는 LoxiLB는 국내에서 만든 오픈소스라고 합니다! eBPF를 핵심 엔진으로 사용하고 Go Language를 지원합니다.

서버 두대 정도로 로드밸런서로 동작하게 할 수 있다고 하는 놀라운 프로젝트입니다.

https://www.cncf.io/projects/loxilb/

LoxiLB

Meet us in Salt Lake City for KubeCon + CloudNativeCon NA · Nov 12-15 · REGISTER TODAY

www.cncf.io

퍼블릭 클라우드의 로드밸런싱 서비스처럼 kubenetes와 다이렉트로 연결되어 로드밸런서로 사용 가능합니다.

eBPF 기술을 사용하여 초고속으로 성능을 개선했습니다.

또한 LoxiLB는 eBPF 기반이지만 Grafana를 통한 모니터링이 가능하게 구성되어 있어서, 관리를 할 수 있다는 장점이 있습니다.

마치며

이번 스터디에서는 k8s에서 사용되는 service type 중 loadbalancer에 대해 살펴보았습니다. loadbalancer는 AWS ELB서비스와 온프레미스용 MetalLB를 많이 사용하는 것으로 알고 있었는데, 스터디를 통해 MetalLB의 단점을 살펴보니 사용을 주저하게 되네요! 마지막에 소개된 LoxiLB에 대해 스터디를 진행하고나면 회사 온프레미스 환경에 사용해볼 수 있을 것 같습니다.

그럼 다음 스터디로 다시 찾아오겠습니다 :)

'클라우드 컴퓨팅 & NoSQL > [KANS] 쿠버네티스 네트워크 심화 스터디' 카테고리의 다른 글

| [7주차 - Service Mesh(Istio)] KANS 스터디 (24.10.13) (0) | 2024.10.17 |

|---|---|

| [6주차 - Ingress & Gateway API] KANS 스터디 (24.10.06) (7) | 2024.10.13 |

| [4주차 - Service : ClusterIP, NodePort] KANS 스터디 (24.09.22) (2) | 2024.09.26 |

| [3주차(2/2) - k8s Calico CNI mode & 운영] KANS 스터디 (24.09.08) (0) | 2024.09.18 |

| [3주차(1/2) - k8s Calico CNI] KANS 스터디 (24.09.08) (1) | 2024.09.18 |

![[5주차 - Service : LoadBalancer] KANS 스터디 (24.09.29)](https://img1.daumcdn.net/thumb/R750x0/?scode=mtistory2&fname=https%3A%2F%2Fblog.kakaocdn.net%2Fdna%2FbNaTtg%2FbtsJVgFeOFv%2FAAAAAAAAAAAAAAAAAAAAAGC6nmgWTysIQn8saOBbrZLuvphuC97yL1qxl6rIUmjf%2Fimg.png%3Fcredential%3DyqXZFxpELC7KVnFOS48ylbz2pIh7yKj8%26expires%3D1772290799%26allow_ip%3D%26allow_referer%3D%26signature%3DNZm%252BDg386PG5gGH8I6TBaqtNsdA%253D)